Rozwój sztucznej inteligencji dostarcza przestępcom bardziej wyspecjalizowanych narzędzi do oszustw. Przez co trudniej jest się zorientować, gdy próbują kogoś oszukać. Klonowanie głosu jest ich najnowszych pomysłem i w ten sposób są w stanie skuteczniej przekonać ofiarę, że naprawdę jej bliska lub znajoma osoba potrzebuje wsparcia finansowego. Jak rozpoznać oszustwo i jak się przed nim chronić?

Jedna z użytkowniczek Facebooka podzieliła się swoją historią ku przestrodze dla innych. Przestępcy wykorzystali w niej sztuczną inteligencję i jej możliwości do klonowania głosu dowolnej osoby.

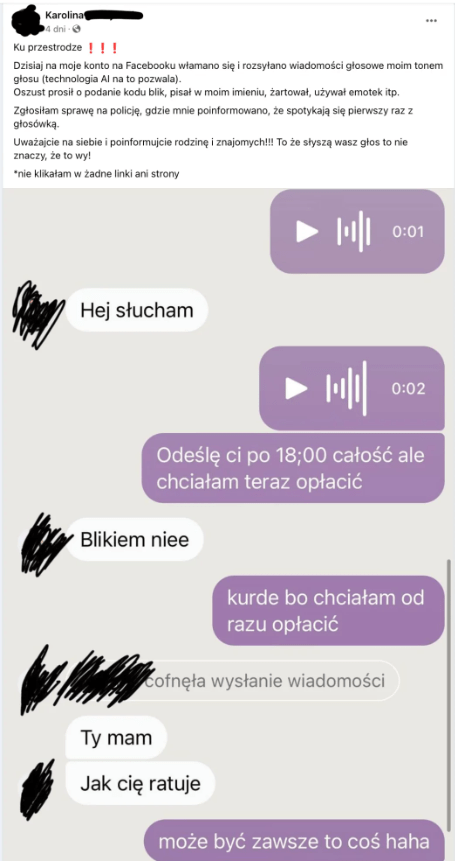

Ku przestrodze! Dzisiaj na moje konto na Facebooku włamano się i rozsyłano wiadomości głosowe moim tonem głosu (technologia AI na to pozwala). Oszust prosił o podanie kodu blik, pisał w moim imieniu, żartował, używał emotek itp. Zgłosiłam sprawę na policję, gdzie mnie poinformowano, że spotykają się pierwszy raz z głosówką. Uważajcie na siebie i poinformujcie rodzinę i znajomych!!! To, że słyszą wasz głos, to nie znaczy, że to Wy! Nie klikałam w żadne linki ani strony – opisała sytuację kobieta.

Zamieściła też screena, który wszystko pokazuje.

Nowa technologia – nowy sposób oszustwa

Cały przebieg oszustwa zaczyna się tak, jak dotychczas, czyli od włamania na konto na Facebooku jednej osoby. Dotychczas wyglądało to tak, że przestępcy rozsyłali wiadomości do jej znajomych z prośbą o przesłanie kodu Blik do wypłacenia pieniędzy. Uzasadniali to pilną potrzeba, problemami z płatnością czy podobnymi kwestiami, które dane osoba mogłaby mieć i potrzebowałaby pomocy znajomego lub członka rodziny.

Teraz przestępcy weszli na wyższy poziom oszustwa z użyciem AI. Wysyłają oni nie wiadomość tekstową, ale wiadomość głosową ze sklonowanym głosem danej osoby. W ten sposób uwiarygadniają, że to ona prosi bliskich o pieniądze. Pokazuje to, jak przestępcy potrafią wykorzystywać zaawansowaną technologie do swoich celów.

Klonowanie głosu przy obecnym dostępie do narzędzi AI nie jest niczym trudnym. Można nawet stosować tłumaczenie głosu na inne języki. Jednak niezmiennie potrzebna jest próbka głosu do klonowania. Ale po włamaniu na konto na Facebooku przestępcy mają dostęp i do tego w stories na Instagramie czy wiadomościach głosowych na Messengerze.

Jak się chronić?

Oszustw tego typu będzie przybywać i coraz trudniej będzie zorientować się, że właśnie jego ofiarą padamy. Rozwój technologii pozwala przestępcom na korzystania z coraz bardziej zaawansowanych narzędzi. Istotne jest, by być świadomym zagrożeń i tego, co przestępcy przeciwko nam są w stanie wykorzystać.

Podstawą jest oczywiście dwuetapowa weryfikacja podczas logowania, którą można ustawić na Facebooku. To pierwsza bariera utrudniająca działania przestępcom. Jeśli nie uda im się włamać na konto pierwszej osoby, to nie będą w stanie wykonać kolejnych kroków do tego oszustwa.

Kolejną kwestią jest ostrożność przy wszelkich wiadomościach od znajomych, w których proszą oni o pieniądze lub jeśli wysyłają podejrzany link. Dobrze jest dopytać o co chodzi albo czy na pewno mają świadomość, co rozsyłają. Istnieją sposoby weryfikacyjne, które można zastosować.

Nawet jeśli wydaje nam się, że rozmawiamy na Messengerze z daną osoba, bo słyszymy jej głos, to możemy o różne rzeczy dopytywać, a najlepiej zadawać pytania, na które nikt poza tą osobą nie zna odpowiedzi. Dla pewności zawsze można zwyczajnie do danej osoby zadzwonić i porozmawiać przez telefon. Wtedy upewnimy się, czy to naprawdę ona prosi o wsparcie.

Źródło: natemat.pl