Kanadyjscy naukowcy sprawdzili, jak ChatGPT radzi sobie w diagnostyce medycznej. Sprawdzali prawidłowość stawianych diagnoz oraz sposób komunikacji. Doszli do wniosku, że chociaż potrafi on pisać czytelne odpowiedzi, to w połowie przypadków podaje błędne diagnozy.

ChatGPT nie daje zgodnych z faktami diagnoz „mimo obszernej informacji, na której był trenowany, a poprawne odpowiedzi dawał tylko w 49 proc. przypadków – stwierdzili naukowcy z Shulich School of Medicine & Dentistry na Uniwersytecie Zachodniego Ontario (Western University).

Naukowcy przetestowali umiejętności ChatGPT na 150 przypadkach pobranych z publicznej bazy danych Medscape. Służy ona m.in. do sprawdzania umiejętności diagnostycznych lekarzy. Sztuczna inteligencja była testowana w taki sam sposób, jak ma to miejsce w przypadku ludzi.

Testy prowadzono między wrześniem 2021 a styczniem 2023 r. Jedynie w 74 przypadkach diagnoza sztucznej inteligencji była trafna. Stanowi to zaledwie 49 proc. sytuacji.

Silnik sztucznej inteligencji ChatGPT nie może być użyty jako narzędzie diagnostyczne w medycynie, bo w ponad połowie przypadków się myli – podsumowali swoje badania kanadyjscy naukowycy.

Dlaczego ChatGPT myli się w diagnozach?

Badacze nie tylko testowali, czy ChatGPT trafnie diagnozuje, ale również sprawdzili, z jakiego powodu się myli.

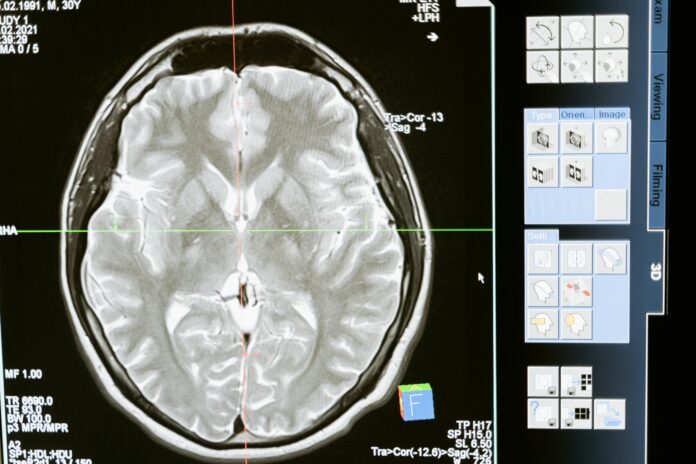

ChatGPT ma problemy z interpretacją wyników laboratoryjnych, wyników obrazowania i pomijał niektóre kluczowe informacje ważne dla diagnozy – napisali autorzy „Oceny ChatGPT jako narzędzia diagnostycznego dla studentów medycyny i klinicystów”

Poza tym odnaleźli „halucynacje AI”. Są to odpowiedzi AI, które są spójne, jednak nie odnoszą się do faktycznych informacji. Wynikają z pominięć, błędów lub przeoptymalizowania danych. Poza tym sztucznej inteligencji zdarza się brak rozeznania w dwuznacznych lub niekompletnych danych wejściowych.

Dlatego nie można wykorzystywać ChatGPT do samodzielnego diagnozowania, gdyż nadzór człowieka i weryfikacji informacji pochodzących od sztucznej inteligencji jest nieodzowny. Jednak można używać tego modelu jako narzędzia pomocniczego. O ile ma problemy z wytypowaniem trafnej diagnozy, to sprawnie odrzuca diagnozy nieprawidłowe. W tym wypadku zdolność do prawidłowego interpretowania danych przez ChatGPT wynosiła 74,33 proc.

– Będziemy potrzebować intensywnego nadzoru nad tym jak sztuczna inteligencja jest używana, by zapewnić bezpieczeństwo pacjenta i by upewnić się, że ten rodzaj technologii AI będzie rozważnie udostępniany – skomentował badanie jego współautor dr Amrit Kirpalani, profesor Schulich School of Medicine & Dentistry.

Źródło: Wirtualne Media